是否能打破人工智能繁荣与萧条的周期循环?

1956年夏天,一群数学家和计算机科学家聚集在达特茅斯学院数学系大楼的顶层。在大约8周的时间里,他们设想了开拓一个新的研究领域的可能性。当时还是达特茅斯学院青年教授的约翰•麦卡锡(John McCarthy)在撰写会议提案时创造了“人工智能”一词,并表示要探索这样一个假设:“原则上,可以精确地描述出学习的每一个方面或智能的任何特征,从而制造出可以模拟的机器。”

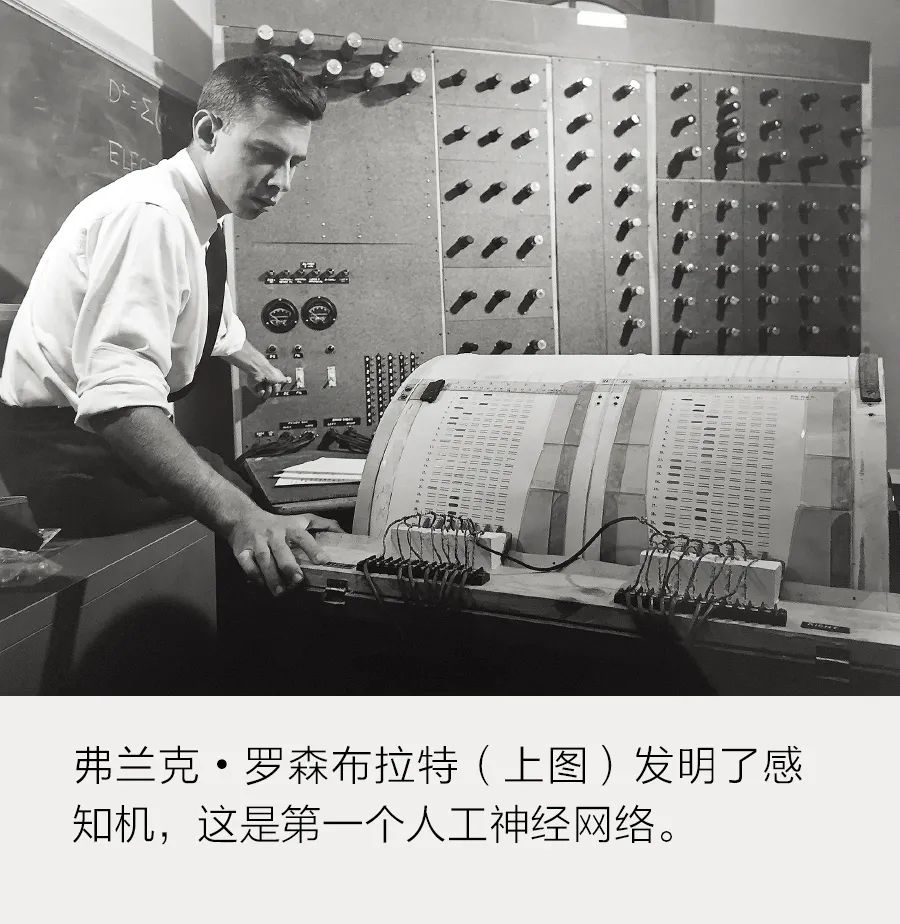

在那次传奇性的会议上,研究人员粗略地勾勒出了我们今天所知道的人工智能。它催生了第一批研究者——“符号主义者”,其专家系统在20世纪80年代达到了顶峰。会议结束后的几年里,还出现了“连接主义者”,他们在人工神经网络领域辛勤研究了几十年,直到最近,这一领域才开始腾飞。长期以来,这两种方法都被认为是相互排斥的,研究人员之间也因经费竞争产生了敌意。双方都认为自己正走在通往通用人工智能的道路上。 那次会议之后的几十年里,人工智能研究人员的希望常常破灭,但这些挫折并没有把他们吓退。如今,虽然人工智能正在推动行业变革并有可能颠覆全球劳动力市场,但许多专家仍在怀疑今天的人工智能是否已经达到了极限。正如查尔斯 •Q. 崔(Charles Q. Choi)《从7个方面看人工智能的失败》中所述,如今深度学习系统的弱点变得越来越明显。然而,研究人员几乎没有什么末日意识。是的,在不远的将来,我们可能会迎来另一个人工智能寒冬。不过,这也可能正是灵感迸发的工程师们最终引领我们进入机器思维之永恒盛夏的时机。开发符号人工智能的研究人员直接向计算机教授有关这个世界的知识。他们的基本宗旨是,知识可以用一组规则来表示,而计算机程序可以用逻辑来操纵这些知识。首屈一指的符号学家艾伦•纽厄尔(Allen Newell)和赫伯特•西蒙(Herbert Simon)认为,如果一个符号系统有足够的结构化事实和前提,那么二者的结合最终将产生广泛的智能。另一方面,连接主义者受生物学启发而致力于“人工神经网络”的研究,这种网络能够接收信息并自己理解信息。康奈尔大学心理学家弗兰克•罗森布拉特(Frank Rosenblatt)在美国海军的资助下建造的实验机器感知机便是一个开创性例子。

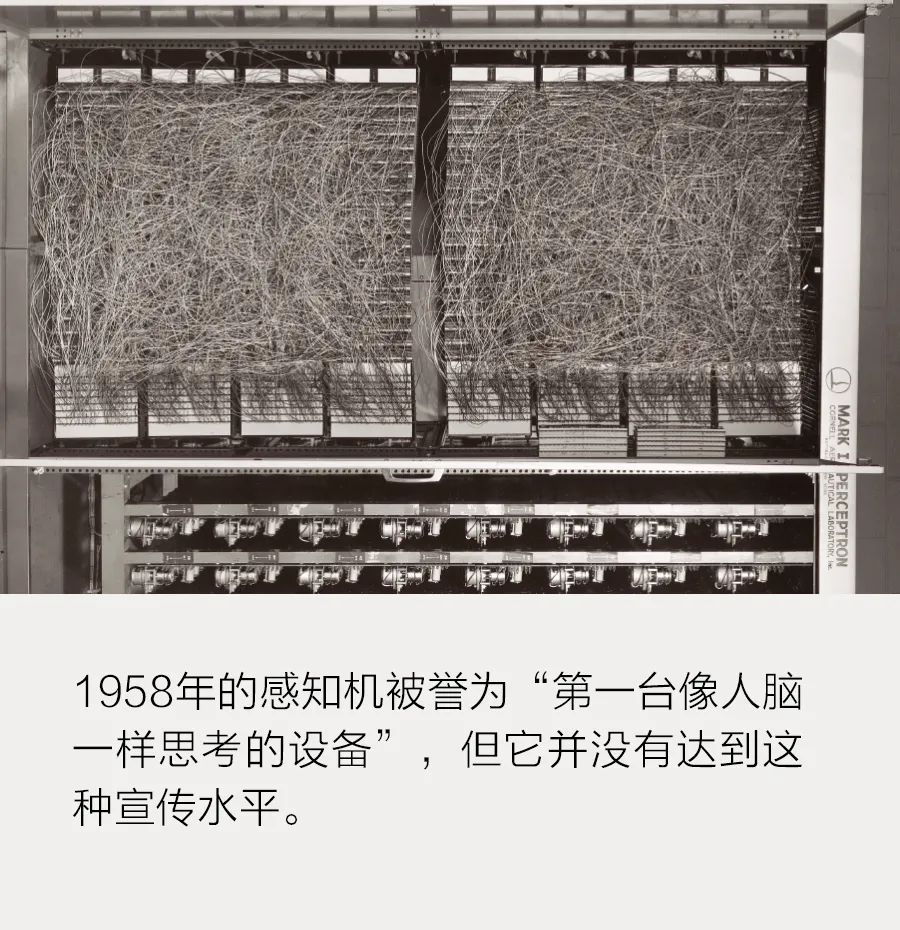

那次会议之后的几十年里,人工智能研究人员的希望常常破灭,但这些挫折并没有把他们吓退。如今,虽然人工智能正在推动行业变革并有可能颠覆全球劳动力市场,但许多专家仍在怀疑今天的人工智能是否已经达到了极限。正如查尔斯 •Q. 崔(Charles Q. Choi)《从7个方面看人工智能的失败》中所述,如今深度学习系统的弱点变得越来越明显。然而,研究人员几乎没有什么末日意识。是的,在不远的将来,我们可能会迎来另一个人工智能寒冬。不过,这也可能正是灵感迸发的工程师们最终引领我们进入机器思维之永恒盛夏的时机。开发符号人工智能的研究人员直接向计算机教授有关这个世界的知识。他们的基本宗旨是,知识可以用一组规则来表示,而计算机程序可以用逻辑来操纵这些知识。首屈一指的符号学家艾伦•纽厄尔(Allen Newell)和赫伯特•西蒙(Herbert Simon)认为,如果一个符号系统有足够的结构化事实和前提,那么二者的结合最终将产生广泛的智能。另一方面,连接主义者受生物学启发而致力于“人工神经网络”的研究,这种网络能够接收信息并自己理解信息。康奈尔大学心理学家弗兰克•罗森布拉特(Frank Rosenblatt)在美国海军的资助下建造的实验机器感知机便是一个开创性例子。 它有400个光传感器,它们共同充当视网膜,能够向大约1000个进行处理并产生单一输出的“神经元”提供信息。1958年,《纽约时报》的一篇文章援引罗森布拉特的话说:“这台机器将是第一台像人脑一样思考的设备。”

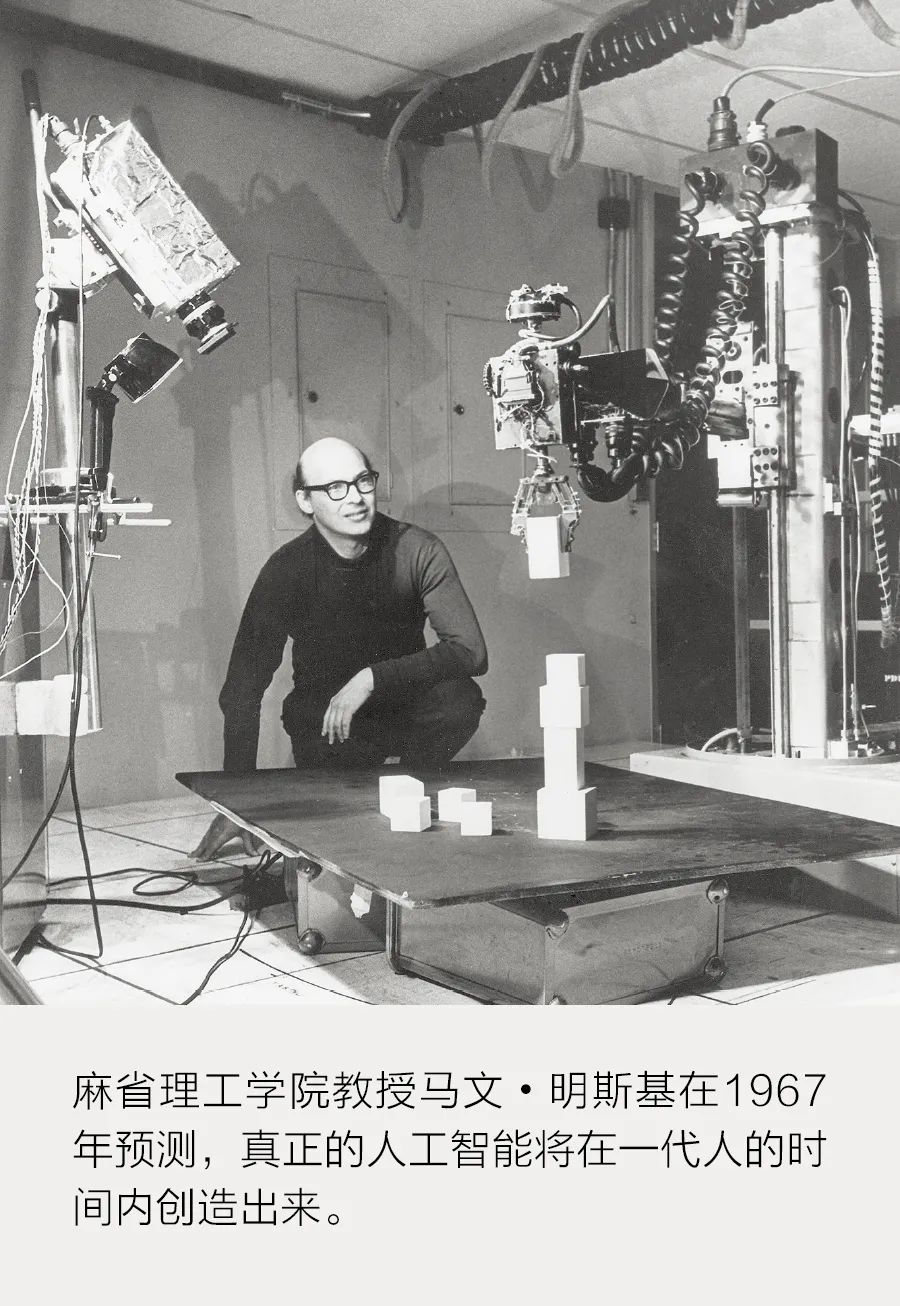

它有400个光传感器,它们共同充当视网膜,能够向大约1000个进行处理并产生单一输出的“神经元”提供信息。1958年,《纽约时报》的一篇文章援引罗森布拉特的话说:“这台机器将是第一台像人脑一样思考的设备。” 在盲目乐观主义的鼓励下,美国和英国政府机构投入了大量资金用于投机性研究。1967年,麻省理工学院教授马文•明斯基(Marvin Minsky)写道:“在一代人的时间之内……创造‘人工智能’的问题将得到实质性解决。”然而此后不久,由于感到人工智能研究没有达到其宣传水平,政府开始停止资助。20世纪70年代出现了人工智能的第一个寒冬。

在盲目乐观主义的鼓励下,美国和英国政府机构投入了大量资金用于投机性研究。1967年,麻省理工学院教授马文•明斯基(Marvin Minsky)写道:“在一代人的时间之内……创造‘人工智能’的问题将得到实质性解决。”然而此后不久,由于感到人工智能研究没有达到其宣传水平,政府开始停止资助。20世纪70年代出现了人工智能的第一个寒冬。 然而,真正的信徒还在继续战斗。到20世纪80年代初,重新燃起的热情为符号人工智能研究人员带来了一个全盛时期,他们因“专家系统”而获得了赞誉和资助,这些系统对法律、医学等特定学科的知识进行了编码。投资者希望这些系统能很快实现商业应用。最著名的符号人工智能风险项目始于1984年,当时研究人员道格拉斯•勒纳特(Douglas Lenat)开始研究一个名为“Cyc”的项目,旨在将常识编码到机器中。时至今日,勒纳特及其团队还在继续向Cyc的本体添加术语(事实和概念),并通过规则解释它们之间的关系。到2017年,该团队已经拥有150万条术语和2450万条规则。然而,Cyc还远未达到通用智能的水平。20世纪80年代末,商业的寒风带来了人工智能的第二个寒冬。专家系统市场崩溃了,因为它们需要专门的硬件,无法与越来越普遍、价格更低廉的台式计算机竞争。到20世纪90年代,学术上都不再流行研究符号人工智能或神经网络,因为这两种策略似乎都失败了。不过,取代专家系统的廉价计算机对连接主义者来说是一个福音,他们突然获得了足够的计算能力来运行具有多层人工神经元的神经网络。这类系统被称为“深度神经网络”,其实现的方法被称为“深度学习”。多伦多大学的杰弗里•辛顿(Geoffrey Hinton)应用了一种叫做“反向传播”的原理来让神经网络从其错误中学习(参见《深度学习的工作原理》)。1988年,辛顿的博士后杨立昆进入了AT&T贝尔实验室,他和一位名叫约书亚•本吉奥(Yoshua Bengio)的博士后将神经网络用于了光学字符识别;很快,美国的银行就采用了这种技术来处理支票。辛顿、杨立昆和本吉奥最终获得了2019年图灵奖,他们有时被称为“深度学习之父”。然而,神经网络倡导者仍然面临一个重大问题:虽然有了理论框架和不断增长的计算能力,但世界上没有足够的数字数据来训练他们的系统,至少对大多数应用来说是这样的。春天还没有到来。在过去20年中,一切都发生了变化。特别是万维网的繁荣发展,突然到处都是数据。互联网上充斥着数码相机和智能手机拍摄的图像,维基百科和Reddit等网站充满了可自由访问的数字文本,YouTube上也有大量视频。最后,我们有了足够的数据来为广泛的应用训练神经网络。另一个重****展得益于游戏业。英伟达等公司开发了一种名为“图形处理单元”(GPU)的芯片,用于电子游戏中渲染图像所需的繁重处理任务。游戏开发者也使用GPU来完成复杂的着色和几何变换工作。需要强大计算能力的计算机科学家则意识到,他们其实可以让GPU去做其他任务,比如训练神经网络。英伟达注意到了这一趋势,因此创建了CUDA平台,让研究人员能够使用GPU进行通用处理。其中有一位来自辛顿实验室的博士生亚历克斯•克里泽夫斯基(Alex Krizhevsky),他用CUDA为一个神经网络编写了代码,该神经网络在2012年给所有人留下了印象的深刻。他写这个代码是为了参加ImageNet竞赛,该竞赛向人工智能研究人员提出了挑战,要求他们搭建起能够将100多万张图像分类为1000种物体的计算机视觉系统。虽然克里泽夫斯基的AlexNet并不是第一个用于图像识别的神经网络,但它在2012年比赛中的表现引起了全世界的注意。AlexNet的错误率为15%,而第二名的错误率为26%。该神经网络的压倒性胜利得益于GPU的强大性能和总计包含65万个神经元的多层“深度”结构。在第二年的ImageNet竞赛中,几乎所有人都使用了神经网络。到2017年,许多参赛者的错误率已降至5%,随后组织者结束了该竞赛。深入学习腾飞了。借助GPU的计算能力和训练深度学习系统的大量数字数据,自动驾驶汽车可以在道路上行驶,语音助手可以识别用户的语音,网络浏览器可以在几十种语言之间进行翻译。人工智能还在几个曾被认为机器无法获胜的游戏中击败了人类冠军,包括古老的围棋和电子游戏《星际争霸II》。前人工智能的繁荣已触及每一个行业,为我们提供了识别模式和做出复杂决策的新方法。不过,深度学习的不断成功依赖于增加神经网络的层数和增加用于训练它们的GPU时间。人工智能研究公司OpenAI的一项分析显示,在2012年之前,训练最大的人工智能系统所需要的计算能力每两年翻一番,此后每3.4个月翻一番。正如尼尔•C.汤普森(Neil C. Thompson)及其同事在《深度学习的回报在减少》一文中所述,许多研究人员担心人工智能的计算需求存在不可持续问题。为了避免破坏地球的能源预算,研究人员需要打破构建这些系统的既定方式。

然而,真正的信徒还在继续战斗。到20世纪80年代初,重新燃起的热情为符号人工智能研究人员带来了一个全盛时期,他们因“专家系统”而获得了赞誉和资助,这些系统对法律、医学等特定学科的知识进行了编码。投资者希望这些系统能很快实现商业应用。最著名的符号人工智能风险项目始于1984年,当时研究人员道格拉斯•勒纳特(Douglas Lenat)开始研究一个名为“Cyc”的项目,旨在将常识编码到机器中。时至今日,勒纳特及其团队还在继续向Cyc的本体添加术语(事实和概念),并通过规则解释它们之间的关系。到2017年,该团队已经拥有150万条术语和2450万条规则。然而,Cyc还远未达到通用智能的水平。20世纪80年代末,商业的寒风带来了人工智能的第二个寒冬。专家系统市场崩溃了,因为它们需要专门的硬件,无法与越来越普遍、价格更低廉的台式计算机竞争。到20世纪90年代,学术上都不再流行研究符号人工智能或神经网络,因为这两种策略似乎都失败了。不过,取代专家系统的廉价计算机对连接主义者来说是一个福音,他们突然获得了足够的计算能力来运行具有多层人工神经元的神经网络。这类系统被称为“深度神经网络”,其实现的方法被称为“深度学习”。多伦多大学的杰弗里•辛顿(Geoffrey Hinton)应用了一种叫做“反向传播”的原理来让神经网络从其错误中学习(参见《深度学习的工作原理》)。1988年,辛顿的博士后杨立昆进入了AT&T贝尔实验室,他和一位名叫约书亚•本吉奥(Yoshua Bengio)的博士后将神经网络用于了光学字符识别;很快,美国的银行就采用了这种技术来处理支票。辛顿、杨立昆和本吉奥最终获得了2019年图灵奖,他们有时被称为“深度学习之父”。然而,神经网络倡导者仍然面临一个重大问题:虽然有了理论框架和不断增长的计算能力,但世界上没有足够的数字数据来训练他们的系统,至少对大多数应用来说是这样的。春天还没有到来。在过去20年中,一切都发生了变化。特别是万维网的繁荣发展,突然到处都是数据。互联网上充斥着数码相机和智能手机拍摄的图像,维基百科和Reddit等网站充满了可自由访问的数字文本,YouTube上也有大量视频。最后,我们有了足够的数据来为广泛的应用训练神经网络。另一个重****展得益于游戏业。英伟达等公司开发了一种名为“图形处理单元”(GPU)的芯片,用于电子游戏中渲染图像所需的繁重处理任务。游戏开发者也使用GPU来完成复杂的着色和几何变换工作。需要强大计算能力的计算机科学家则意识到,他们其实可以让GPU去做其他任务,比如训练神经网络。英伟达注意到了这一趋势,因此创建了CUDA平台,让研究人员能够使用GPU进行通用处理。其中有一位来自辛顿实验室的博士生亚历克斯•克里泽夫斯基(Alex Krizhevsky),他用CUDA为一个神经网络编写了代码,该神经网络在2012年给所有人留下了印象的深刻。他写这个代码是为了参加ImageNet竞赛,该竞赛向人工智能研究人员提出了挑战,要求他们搭建起能够将100多万张图像分类为1000种物体的计算机视觉系统。虽然克里泽夫斯基的AlexNet并不是第一个用于图像识别的神经网络,但它在2012年比赛中的表现引起了全世界的注意。AlexNet的错误率为15%,而第二名的错误率为26%。该神经网络的压倒性胜利得益于GPU的强大性能和总计包含65万个神经元的多层“深度”结构。在第二年的ImageNet竞赛中,几乎所有人都使用了神经网络。到2017年,许多参赛者的错误率已降至5%,随后组织者结束了该竞赛。深入学习腾飞了。借助GPU的计算能力和训练深度学习系统的大量数字数据,自动驾驶汽车可以在道路上行驶,语音助手可以识别用户的语音,网络浏览器可以在几十种语言之间进行翻译。人工智能还在几个曾被认为机器无法获胜的游戏中击败了人类冠军,包括古老的围棋和电子游戏《星际争霸II》。前人工智能的繁荣已触及每一个行业,为我们提供了识别模式和做出复杂决策的新方法。不过,深度学习的不断成功依赖于增加神经网络的层数和增加用于训练它们的GPU时间。人工智能研究公司OpenAI的一项分析显示,在2012年之前,训练最大的人工智能系统所需要的计算能力每两年翻一番,此后每3.4个月翻一番。正如尼尔•C.汤普森(Neil C. Thompson)及其同事在《深度学习的回报在减少》一文中所述,许多研究人员担心人工智能的计算需求存在不可持续问题。为了避免破坏地球的能源预算,研究人员需要打破构建这些系统的既定方式。 虽然神经网络阵营似乎已经彻底击败了符号主义者,但事实上,这场战争的结果远没有那么简单。以OpenAI因操作和解魔方而成为头条新闻的机械手为例。该机器人使用了神经网络和符号人工智能。它是诸多新型神经符号系统之一,它使用神经网络进行感知,使用符号人工智能进行推理,这种混合方法既可以提高效率也能提高可解释性。虽然深度学习系统往往像是以不透明和神秘方式进行推理的黑匣子,但神经符号系统能够让用户深入了解人工智能是如何得出结论的。正如埃文•艾克曼(Evan Ackerman)在《深度学习进入新兵训练营》中所述,美国陆军特别警惕依赖黑匣子系统,因此陆军研究人员正在研究各种混合方法来推动其机器人和自动驾驶车辆的发展。想象一下,你能否使用陆军的一个道路清理机器人并让它给你煮一杯咖啡。这在今天是一个可笑的命题,因为深度学习系统是为狭义的目的而建立的,不能将其能力从一项任务推广到另一项任务。更重要的是,学习一项新任务通常需要人工智能擦除它知道的所有关于如何解决先前任务的信息,这个难题被称为“灾难性遗忘”。在谷歌位于伦敦的人工智能实验室DeepMind,著名的机器人学家拉亚•哈塞尔(Raia Hadsell)正在用各种复杂的技术解决该问题。在《如何训练多用途机器人》一文中,汤姆•奇弗斯(Tom Chivers)解释了为什么该问题对于在不可预知的现实世界中行动的机器人如此重要。其他研究人员正在研究新型元学习,以期开发出能够学习怎样学习,然后将该技能应用于任何领域或任务的人工智能系统。

虽然神经网络阵营似乎已经彻底击败了符号主义者,但事实上,这场战争的结果远没有那么简单。以OpenAI因操作和解魔方而成为头条新闻的机械手为例。该机器人使用了神经网络和符号人工智能。它是诸多新型神经符号系统之一,它使用神经网络进行感知,使用符号人工智能进行推理,这种混合方法既可以提高效率也能提高可解释性。虽然深度学习系统往往像是以不透明和神秘方式进行推理的黑匣子,但神经符号系统能够让用户深入了解人工智能是如何得出结论的。正如埃文•艾克曼(Evan Ackerman)在《深度学习进入新兵训练营》中所述,美国陆军特别警惕依赖黑匣子系统,因此陆军研究人员正在研究各种混合方法来推动其机器人和自动驾驶车辆的发展。想象一下,你能否使用陆军的一个道路清理机器人并让它给你煮一杯咖啡。这在今天是一个可笑的命题,因为深度学习系统是为狭义的目的而建立的,不能将其能力从一项任务推广到另一项任务。更重要的是,学习一项新任务通常需要人工智能擦除它知道的所有关于如何解决先前任务的信息,这个难题被称为“灾难性遗忘”。在谷歌位于伦敦的人工智能实验室DeepMind,著名的机器人学家拉亚•哈塞尔(Raia Hadsell)正在用各种复杂的技术解决该问题。在《如何训练多用途机器人》一文中,汤姆•奇弗斯(Tom Chivers)解释了为什么该问题对于在不可预知的现实世界中行动的机器人如此重要。其他研究人员正在研究新型元学习,以期开发出能够学习怎样学习,然后将该技能应用于任何领域或任务的人工智能系统。 所有这些策略都可能有助于研究人员实现其最崇高的目标:用我们看到的儿童所发展出的流动智力来构建人工智能。幼儿不需要大量数据来得出结论。他们只是观察世界,创建一个关于世界如何运作的心智模型,采取行动,并利用行动的结果来调整其心智模型。他们会反复迭代直到理解为止。这个过程非常高效,甚至远远超出了当今最先进的人工智能的能力。

所有这些策略都可能有助于研究人员实现其最崇高的目标:用我们看到的儿童所发展出的流动智力来构建人工智能。幼儿不需要大量数据来得出结论。他们只是观察世界,创建一个关于世界如何运作的心智模型,采取行动,并利用行动的结果来调整其心智模型。他们会反复迭代直到理解为止。这个过程非常高效,甚至远远超出了当今最先进的人工智能的能力。 当前的热情使人工智能获得了其加德纳技术成熟度曲线,而且有关人工智能的资金已经达到了历史最高水平,鲜有证据表明我们的未来会失败。世界各地的公司都在采用人工智能系统,因为它们看到自己的盈亏底线立即得到了改善,而且他们不会回头。现在就看研究人员能否找到适应深度学习的方法并使其更灵活、更稳健,或者设计出我们在让机器变得更像人类的65年探索过程中从未想过的新方法。

当前的热情使人工智能获得了其加德纳技术成熟度曲线,而且有关人工智能的资金已经达到了历史最高水平,鲜有证据表明我们的未来会失败。世界各地的公司都在采用人工智能系统,因为它们看到自己的盈亏底线立即得到了改善,而且他们不会回头。现在就看研究人员能否找到适应深度学习的方法并使其更灵活、更稳健,或者设计出我们在让机器变得更像人类的65年探索过程中从未想过的新方法。*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。