来源:AI前线

编译 | 凌敏,核子可乐

Meta 公司称,这款模型在文生图方面的表现,达到了业界最高水平。Meta 开发出文生图模型

CM3Leon

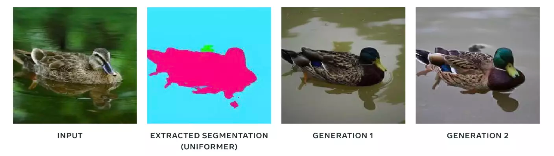

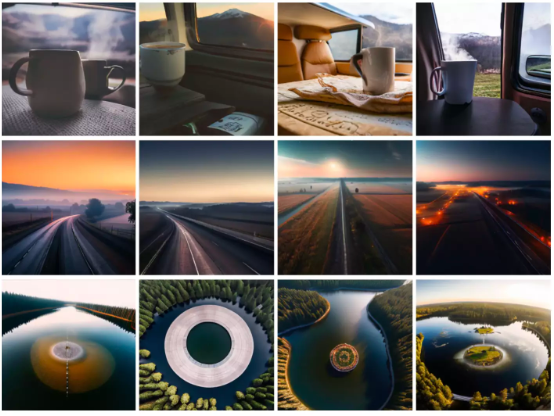

近日,Meta 公司宣布开发出一款名为 CM3Leon(发音类似「chameleon」)的文生图模型,该模型能够独力解决文本到图像和图像到文本的双向生成任务。Meta 表示:“在打造高质量生成模型的探索之路上,我们相信 CM3leon 在各类任务中的强大性能,正是迈向高保真度图像生成与理解的重要一步。像 CM3leon 这样的模型终将成为元宇宙中的创造力源泉与应用成果,我们也期待继续突破多模态语言模型的新疆界、未来将更多优秀模型呈现在大家面前。”据介绍,CM3leon 是首个使用纯文本语言模型配方改编和训练而成的多模态模型,并经历了大规模检索增强预训练和随后的多任务监督微调(SFT)阶段。与 Stable Diffusion、DALL-E、Midjourney 等文生图模型依赖于扩散(diffusion)模型技术不同,CM3Leon 采用了基于 token 的自回归模型方法。Meta 表示,尽管训练时的计算量仅相当于以往基于 Transformer 方法的五分之一,但 CM3leon 在文本到图像的生成方面还是获得了同类领先的性能。CM3leon 既具备自回归模型的功能多样性和有效性,也保持着较低的训练成本和良好的推理效率。作为一套因果掩码混合模态(CM3)模型,它能够以其他图像和文本内容的任意序列为条件,生成相应的文本与图像序列。这极大扩展了以往大模型只能从文本到图像、或者只能从图像到文本的功能局限。一般来讲,纯文本生成模型往往会针对各类不同任务进行多任务指令调整,借此增强其遵循指令提示的能力;而图像生成模型则更多适配特定任务。Meta 将大规模多任务指令调节运用到 CM3leon 的图像和文本生成当中,事实证明能够显著提高图像标题生成、视觉问答、基于文本的图像编辑和按条件生成图像等能力。这也成为强有力的实例,证明为纯文本模型开放的扩展配方也能直接推广到基于 token 化的图像生成模型当中。Meta 称,与目前广泛使用的图像生成基准(零样本 MS-COCO)进行性能比较时,CM3leon 获得了 4.88 的 FID(Fréchet Inception Distance,一种用于计算真实图像与生成图像间特征向量距离的指标,FID 值越小则相似度越高,最好为 0),超越谷歌的文本到图像模型 Parti,证明了自身技术的先进性。此外,CM3leon 还表现出令人印象深刻的复杂组合对象生成能力。CM3leon 在各类视觉语言任务中均表现良好,包括视觉问答和生成长格式标题。由于训练数据集仅包含 30 亿文本 token,因此 CM3leon 的零样本性能也超越了由更广泛数据集训练而成的、体量更大的其他模型。CM3leon 是如何打造出来的?据介绍,CM3leon 架构采用的是类似基于文本类模型、已经成熟的纯**** Transformer。但它的独特之处,在于能够同时输入和生成文本加图像。正是凭借这种能力,CM3leon 才得以成功解决前文提到的各项任务。训练方面,Meta 表示,通过一系列努力,CM3leon 的训练检索得到了增强,大大提高了模型成果的效率和可控性。此外,Meta 还根据各种不同图像和文本生成任务对模型进行了指令微调。随着 AI 行业的不断发展,像 CM3leon 这样的生成模型正变得越来越复杂。这些模型通过数百万的示例图像接受训练,学习视觉效果与文本之间的关系,但同时也可能反映训练数据集中存在的偏差 / 偏见。Meta 称,目前 AI 行业仍处于理解和应对这些挑战的早期阶段,提升透明度才是加速解决这些问题的关键。Meta 使用许可数据集作为 CM3leon 的训练素材。在预训练阶段,Meta 使用了数百万张来自 Shutterstock 的授权图片,有着高达 70 亿个参数,这也达到了 OpenAI EALL-E2 模型的两倍以上。Meta 方面表示:“在文本到图像生成领域,图像数据来源的道德影响已经引发了广泛的讨论。在这一研究中,我们只使用 Shutterstock 上的经过授权的图像,因此可以避免与图像所有权和归属相关的担忧,同时不会牺牲性能。”事实证明,即使使用与先前所有模型的训练数据都截然不同的数据分布,仍可实现强大的性能。通过全工作流程的透明展示,Meta 希望鼓励生成式 AI 领域能够迎来更多合作与创新,打造出不仅更准确、而且对每个人都更加公平和公正的 AI 模型。CM3leon 的跨任务执行CM3leon 的强大之处在于更好地遵循输入提示以生成更连贯的图像。例如,多数原有图像生成模型都难以准确还原全局形态和局部细节,而 CM3leon 在这方面表现出色,以下是 CM3leon 在各类任务中的表现(所有任务均由单一模型处理完成):文本引导的图像生成与编辑一般来说,如果约束条件要求将复杂的对象或提示全部体现在输出结果中时,图像生成模型往往难以很好地完成工作。这就让文本引导的图像编辑(例如“将天空的颜色更改为蔚蓝色”)更具挑战,因为模型需要同时理解文本指令与视觉内容。CM3leon 在这类场景下表现良好,具体请参考以下示例。1.文本到图像给定具有潜在高组合度结构的提示文本,生成遵循提示的连贯图像。例如,CM3leon 根据提示词创建了以下四幅图像:

例如,图像内容为一只狗叼着一根棍子。提示问题: 狗叼着什么?模型输出: 棍子提示词: 详细描述这张图像的内容。模型输出: 在这张图片中,有一只狗嘴里叼着一根棍子。地面有草覆盖,背景中是一片林地。

以下是更多生成示例:

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。