谷歌一直坚信虚拟现实身临其境的力量,但要创建最为逼真的临场感,在VR中展示的内容需要尽可能接近看到的内容。

光场是一种先进的捕捉,拼接和渲染算法。通过为静态捕捉图像生成运动视差和非常逼真的纹理和光照,光场可以向你提供极高质量的临场感。为了展示这种技术的潜力,谷歌曾经在Steam上发行了免费应用“Welcome to Light Fields”,支持HTC Vive,Oculus Rift和WMR头显。

谷歌的光场技术

捕捉和处理光场

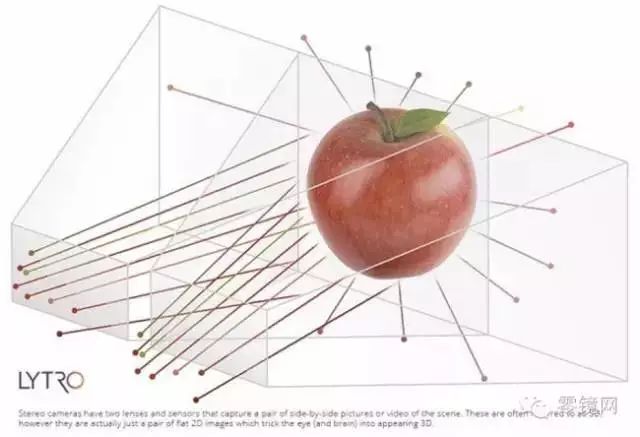

对于光场,附近的对象似乎相当靠近你。当你移动头部的时候,它们看起来的变化会很大。远处的对象变化较少,不同对象的光线****也不同,因此你会得到强烈的暗示,认为自己正身处于3D空间之中。当通过支持位置追踪的VR头显进行浏览时,光场可以根据真实世界中捕获的片段实现真正令人惊叹的VR体验。

这一切的原因在于光场可以记录进入空间的所有不同光线。为了记录它们,谷歌改装了一台GoPro Odyssey Jump相机平台,将其弯曲成16个镜头的垂直弧形并安装在旋转平台上。

左:在发现号航天飞船甲板上拍摄的球形光场延时拍摄视频。

右:光场渲染允许我们通过对镜头记录的光线进行采样和插值,并且在球形空间内的任何位置合成新场景视图。

相机平台旋转并录制70厘米球体上的大约1000个外向视角大概需要1分钟。这提供了一个两英尺宽的光线量,而后者决定了顶部空间的大小,亦即用户为探索场景而转动头部的空间。为了向头显渲染视图,谷歌从球体表面上的相机位置采样光线,从而构建从球体内部看到的新视图,并以此匹配用户移动头部的方式。它们在一个自定义数据集文件中对齐和压缩,据小编了解谷歌是通过作为Unity游戏引擎插件的特殊渲染软件读取这个数据集文件。

用光场记录世界

谷歌选择了数个特殊场所来测试他们的光场相机平台。谷歌表示,他们钟爱帕萨迪纳盖博住宅(Gamble House)的亮漆柚木和红木内饰,威尼斯马赛克小屋(Mosaic Tile House)的光泽陶瓷和闪亮,以及格拉纳达山圣斯蒂芬教堂那阳光潋滟的彩色玻璃窗。最重要的是,史密森学会的航空航天博物馆和3D数字化办公室允许谷歌进入NASA的发现号航天飞船,在这个不对外开放的飞行甲板中为我们提供宇航员的视角。最后谷歌录制了一系列的光场,并且实验了眼神接触如何应用于6自由度体验。

VR视频是探索世界的一项光明技术。尽管只是实验,但光场向我们展示了VR体验可以实现的逼真水平 。

VR视频和全景视频的区别

VR视频与全景视频有什么区别?

我们用一张图来说明360度全景视频和VR视频的不同:

全景视频很好理解,就是有别于传统视频单一的观看视角,让人们可以360度自由观看。而VR视频在此基础上,还允许人们在视频里自由移动观看(提供场景中任意位置的360度自由视角)。

全景视频可以是3D的也可以不是,可以通过屏幕观看,也可以带上眼镜观看。而VR视频必须带上头显观看,且必须是3D的。

全景视频是线性播放的,也就是按照时间轴来进行回放的。而VR视频可以允许用户在同一时间,站在不同的位置观看(有点类似科幻电影里时间暂停了,然后观察者在定格的时间和空间里任意移动,观看周围的人物和景物)。

全景视频和VR视频有什么相似之处?

1.都可以是3D的(全景视频也有2D版);

2.都能360度上下、左右旋转观看;

3.具有视觉沉浸感。

那有什么不同呢?

最大区别就是VR视频允许观看者在场景里自由走动观察,但全景视频不行,拍摄机位在哪儿,观看者就必须在哪儿,顶多只能原地360度观看。

如果是一部VR电影,那么传统的“镜头运动、场景切换、Zoom In or Zoom Out”可能都将被取代,由观众来决定镜头位置。你可以把VR视频看成是“3D全景视频+自由移动”。

所以,现在大家所看到的基本都是“伪VR视频”,各大视频网站上标称的VR视频也基本都是360度全景视频。而打着“VR相机”口号行销的其实大部分都是360度全景相机。那么,我们不禁要问,真正的VR视频是什么样呢?

真正的VR视频目前只能通过CG实现

如何才能拍摄出真正的VR视频呢?很遗憾,以现在的技术手段和设备能力还很难实现。所以到目前为止,我们还没有看到过一部真正意义上的VR视频是被实际拍摄出来的。因为一台摄像机只能捕捉一个位置的光线,而要实现场景里的自由移动,需要捕捉场景里任意位置的光线,显然我们无法在场景里安置那么多摄像机,这是矛盾的。现今的谷歌光场技术是否能解决这问题?

那未来有没有可能呢?答案是肯定的。

要拍摄真正意义上的VR视频,我们需要光场摄像机。

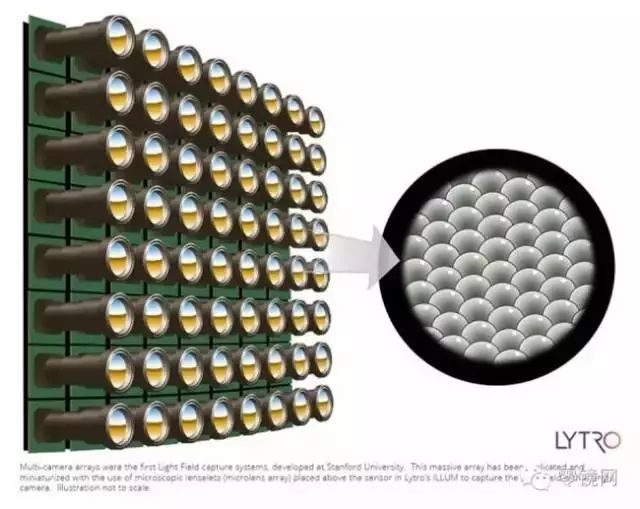

什么是光场摄像机?这绝对是一个黑科技,很难用几句话表述清楚。大概意思就是通过矩阵式摄像头(非常非常多的微型摄像头),捕捉和记录周围不同角度射入的光线信号,再利用计算机后期合成出任意位置的图像。

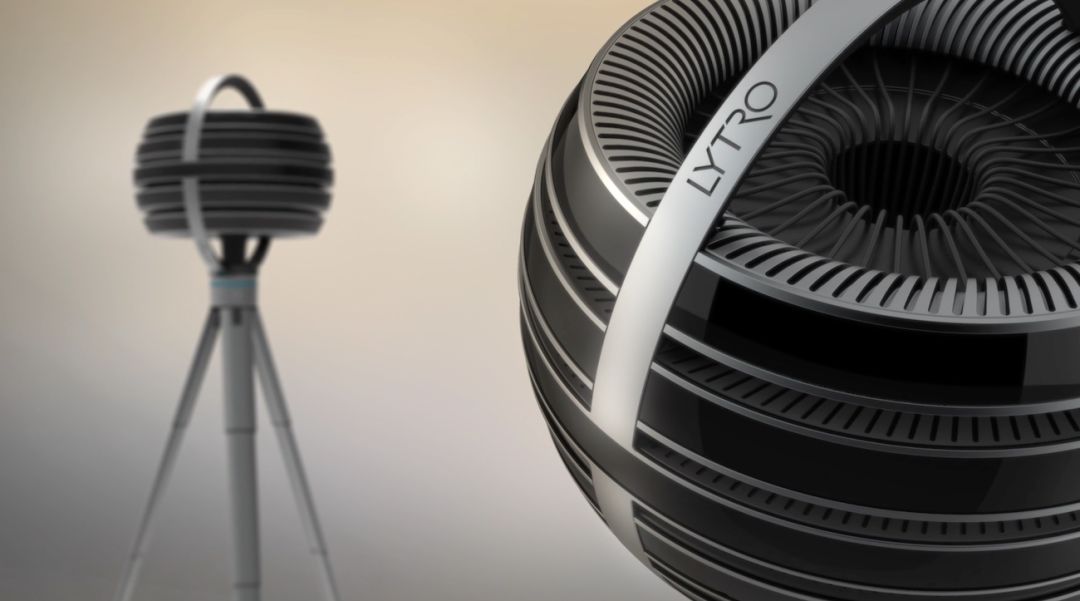

Lytro公司去年发布的360度光场摄像机

Immerge,其内部的数百个镜头和图像传感器分为五个“层”(你可以想象每层都是20部GoPro相机组合在一起),除此之外还配套专用的服务器和编辑工具等。

与传统摄像机不同的是,光场摄像机除了记录色彩和光线强度信息外,还会记录光线的射入方向——这就是“光场”技术的由来。

有了从四面八方射入的光的方向信息,再利用算法,就能对环境进行分析,逆向建模,从而还原出一个三维的环境模型。这和计算机建模(CG)的结果是相似的,只不过CG是人为主观“虚构”模型,而光场摄像机是逆向方式“客观”还原模型。

有了三维模型,计算机便可以实时计算出任意位置的视觉图像,3D+360度全景也没有问题。这就是说,光场摄像机所在的位置拍摄到的景象是真实的,而自由移动位置后看到的景象是通过电脑后期合成的。

Lytro公司坦言目前他们只能做到视角在一定范围的左右和前后移动,要想“看到”物体背面的样子还不行(也许要对反射光进行计算和建模)。所以要实现真正意义上的VR视频,还是电脑建模然后实时渲染输出最简单。

如今所有的VR游戏,都可以看作是VR视频。不仅可以3D显示+360度全景,还可以自由移动,甚至控制时间轴也没有问题。只是,VR视频都用计算机建模了,还有拍摄什么事情呢?我们要继续讨论VR视频的拍摄过程吗?

当然要,全景视频虽然是“伪VR视频”,但全景视频还是可以被认为是VR视频的初级阶段。因为全景视频加上3D效果也能带来沉浸感,相比普通视频已经有了质的飞跃,应用领域也非常广阔,值得我们去尝试和探索。

未来VR的呈现方式会趋向多元化,头显本身的发展也会从目前眼前单一屏幕向光场化真实化迈进,目前以Magic Leap为代表的国内外研究机构在光场头戴式显示进行探索,这种头显可以让人眼聚焦在虚拟物体的不同深度,而不是一块显示屏上; 最后,应用方式上,谷歌Welcome to Light Field为我们提供了一个很好的范例,更好的光场应用方式还需要进一步研究探索,比如,虚拟的光场和真实世界的逼真融合以及自然的交互也会成为学界和产业界的热点。"

- END -

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。